“اطلاعی ندارم!” درد داره؟! بررسی دقیق توهم مدل ها

پادکست “اطلاعی ندارم!” درد داره؟! بررسی دقیق توهم مدل ها را از اینجا بشنوید:

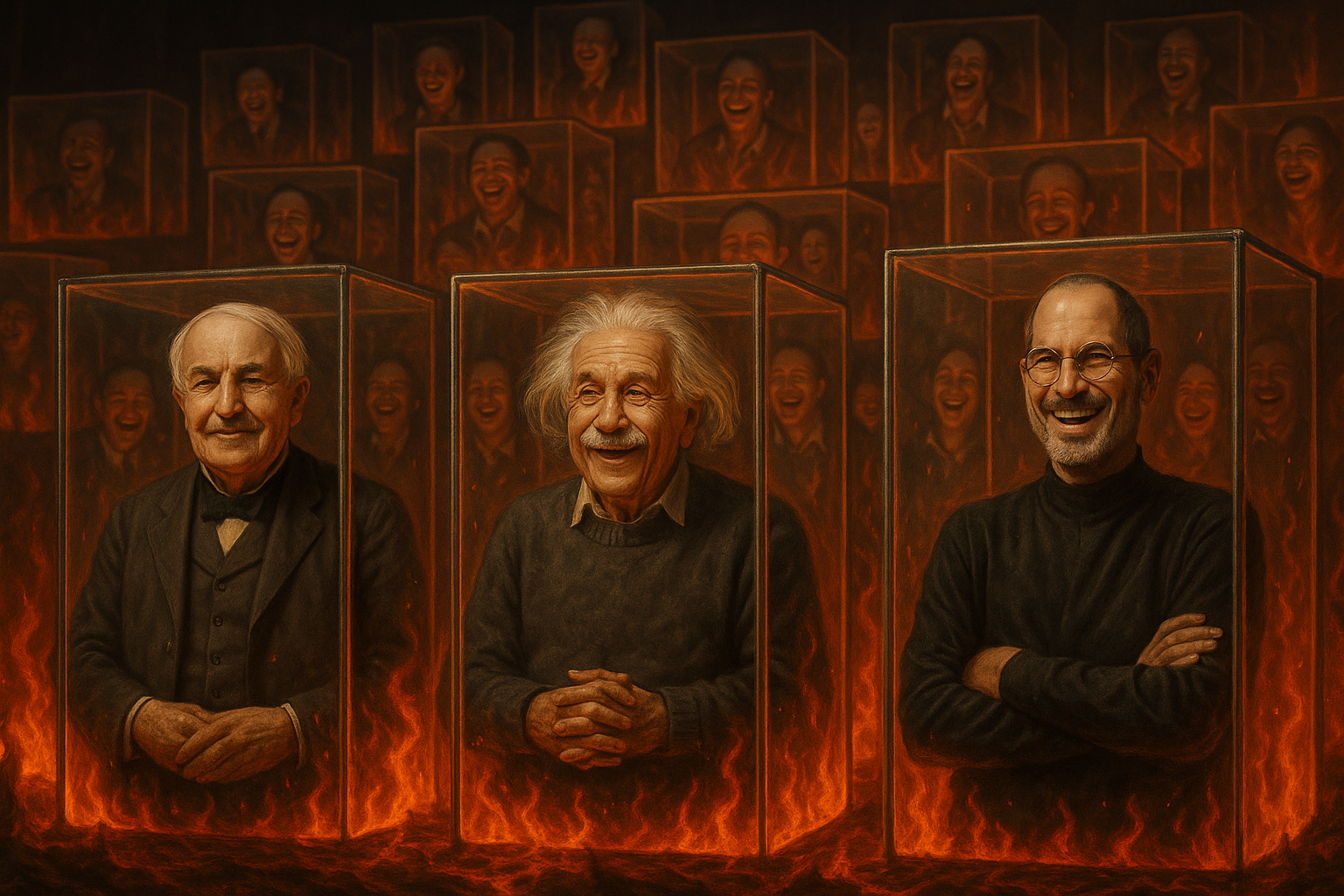

چند سال پیش یه برنامه رو میدیدم که مثل اغلب برنامه های پر تاثیر و پر جاذبه مذهبی تولید ملی، گفتگوی یک مجری با یک روحانی رو نشون میداد، حاج آقا داشتند سوالات مردمی رو جواب میدادند، مجری سوال بعد رو خوند : “سلام و عرض ادب خدمت حاج آقای …. ، از محضرتون یک سوال داشتم ، ادیسون میره تو بهشت یا عذاب میشه؟”

حاج آقا شروع به پاسخ دادن کردند : ادیسون به خاطر خدماتی که داشته اما در عین حال خب مسلمان نبوده و فلان بهمان ….. بنابر این در یک صندوقچه ای قرار میگیره که آسیب جدی بش نرسه اما در جهنم هست!!

حالا فارغ از سوال چرتی که این مخاطب پرسیده ، فارغ از برنامه ی چرتی که این سوالات رو میاره ، فارغ از مجری و ناظر و دست اندرکاران برنامه که همه چرت !

حاج آقا ، نمیدونم درد داره؟! به من چه به توچه درد داره؟! از رفعت علمی تون کاسته میشه بگید نمی دانم؟! اطلاعی ندارم؟!

امروز در تلگرام یک مقاله بسیار کاربردی دیدم که تیم نبراس هم مدتیه درگیر تحقیق و توسعه برای رفع و بهبود این موضوع هستند. این مقاله در مورد یک مسئله بسیار مهم در حوزه هوش مصنوعیه که اخیراً توجه زیادی رو به خودش جلب کرده؛ مشکلی که بهش میگن «توهم مدلها» یا به انگلیسی “Hallucination”.

داستان از این قراره که وقتی از مدلهای هوش مصنوعی (مثل GPT یا Gemini) استفاده میکنیم و بهشون اطلاعات بیرونی میدیم تا جواب دقیقی به سؤالات ما بدن (سیستمی به اسم RAG)، گاهی اوقات مدلها با اعتماد به نفس بالا پاسخهایی ارائه میدن که اصلاً توی اطلاعات موجود نیست! این حالت خیلی شبیه اینه که مدل «توهم» زده باشه و جواب رو از خودش ساخته باشه!

توی این مقاله که عنوانش «Sufficient Context: A New Lens on Retrieval-Augmented Generation Systems» هست، نویسندهها یک مفهوم خیلی جذاب معرفی کردن به اسم «متن کافی». به زبان ساده یعنی اینکه چطور بفهمیم اطلاعاتی که به مدل میدیم برای پاسخدادن کافی هست یا نه.

حالا چرا این مهمه؟ چون وقتی مدل جواب اشتباه میده، ما دقیقاً نمیدونیم مشکل از کجاست: آیا اطلاعات ناقصه یا مدل نتونسته درست تحلیلش کنه؟ اگه بتونیم این موضوع رو روشن کنیم، میتونیم راههای خیلی بهتری برای آموزش و بهبود مدلها پیدا کنیم.

نویسندههای مقاله یک سیستم هوشمند جالب ساختن (یه جور داور هوش مصنوعی) که میتونه به صورت خودکار تشخیص بده آیا متنی که به مدل داده شده، برای جواب دادن به سوال کافیه یا نه. جالبه که این سیستم تونسته با دقت ۹۳ درصد درست تشخیص بده! این یعنی قدم بزرگی برای بهتر کردن کیفیت پاسخها.

نتیجههای مقاله هم خیلی جذابه. مشخص شده که مدلهای بزرگتر مثل GPT-4o وقتی اطلاعات کافی داشته باشن معمولاً عالی عمل میکنن، ولی مشکل اصلی اینجاست که وقتی اطلاعات ناکافیه، به جای اینکه صادقانه بگن «نمیدونم»، یه جواب بیربط میسازن! از طرف دیگه، مدلهای کوچیکتر مثل Gemma حتی وقتی اطلاعات کافیه هم باز ممکنه جواب اشتباه بدن.

جذابتر اینکه گاهی مدلها حتی با اطلاعات ناکافی جواب درست میدن، چون از قبل یه چیزایی میدونن (مثل آدمایی که بدون کتاب و جزوه امتحان قبول میشن 😅).

خلاصه اینکه تیم ما توی نبراس هم دقیقاً داره روی این موضوع کار میکنه که چطور میشه جلوی این توهمها رو گرفت و مطمئن شد جوابهایی که سیستم میده قابل اعتمادن.

ایده استفاده از ارزیاب متن کافی و ترکیب اون با میزان اعتماد مدل رو دقیقا ماهم روش داریم کار میکنیم، اسمش رو هم گذاشته بودیم “اطلاعی ندارم!”، هدف اصلی هم یه جمله ست فقط : “وقتی نمیدونی بگو نمیدانم! اطلاعی ندارم!” این مقاله رو که دیدم خیلی خوشحال شدم که مسیرمون درست بوده.

کاش ما انسان ها هم یه مدل “ارزیاب دانش کافی” درون داشتیم که وقتی در مورد آب میان بافتی سلول های هیپوزکومی بحث میشد در ادامه نمی گفتیم که : “اتفاقا این سلول های هیپوزکومی کنارشون یه بافت هایی شکل میگیره که … ” ، آقا بگو نمیدانم!! چته؟! شما هم قطعا نمیدانید! چون اصلا چیزی به نام سلول های هیپوزکومی وجود نداره به قرآن الان از خودم در آوردم!

اگه دوست دارین در این مورد بیشتر بدونین، پیشنهاد میکنم حتماً مقاله اصلی رو یه نگاهی بندازین: «Sufficient Context: A New Lens on Retrieval-Augmented Generation Systems»